Tecnología

“Hey, @Grok, ¿esto es cierto?”: investigación reveló qué tan confiables son realmente las respuestas de estos chatbots

Usuarios de X cuestionan la fiabilidad de Grok tras respuestas polémicas sobre un supuesto “genocidio blanco”.

Desde su lanzamiento en noviembre de 2023, Grok, el chatbot de inteligencia artificial generativa de xAI, la compañía de Elon Musk, se ha convertido en un actor recurrente en las conversaciones de la red social X (antes Twitter). Su uso se disparó cuando en diciembre de 2024 se extendió a los usuarios no prémium, lo que provocó una avalancha de preguntas como: “Hey, @Grok, ¿esto es cierto?”.

A primera vista, consultar a una IA parece una forma rápida de verificar datos en medio del caos informativo de las redes sociales. Pero, ¿qué tan precisas y confiables son realmente las respuestas que ofrecen estas herramientas?

Fallos repetidos: desde datos imprecisos hasta citas falsas

Una encuesta reciente de TechRadar indica que el 27 % de los estadounidenses ha sustituido los buscadores tradicionales como Google o Yahoo por herramientas de IA como ChatGPT (OpenAI), Gemini (Google), Copilot (Microsoft), Meta AI o Perplexity. Sin embargo, los estudios revelan que estas plataformas están lejos de ser infalibles.

En febrero de 2025, la BBC realizó una investigación en la que se pidió a varios chatbots que respondieran preguntas usando noticias reales del medio británico.

Lo más leído

- El resultado fue preocupante: el 51 % de las respuestas presentaban “problemas significativos de algún tipo”.

- De ese total, el 19 % contenía errores fácticos añadidos por la IA y el 13 % incluía citas alteradas o inexistentes.

“El problema no es solo que se equivoquen, sino que lo hagan con seguridad”, advirtió Pete Archer, director del Programa de IA Generativa de la BBC. “Los asistentes de IA no pueden considerarse actualmente fuentes fiables de noticias y corren el riesgo de desinformar a la audiencia”.

Confianza injustificada y respuestas especulativas

Una reciente investigación adicional del Tow Center for Digital Journalism, publicada en marzo de 2025 por la Columbia Journalism Review, reveló que los chatbots presentan respuestas incorrectas con una “confianza alarmante”. El estudio analizó ocho herramientas de búsqueda con IA generativa y encontró que Perplexity fue la más precisa, con una tasa de error del 37 %, mientras que Grok falló en el 94 % de las consultas.

“ChatGPT identificó erróneamente 134 artículos, pero solo expresó dudas en quince de sus doscientas respuestas, y nunca se negó a responder”, indica el informe.

En general, los investigadores concluyeron que estas plataformas son “poco competentes a la hora de rechazar preguntas cuya respuesta no podían dar con precisión, ofreciendo en su lugar respuestas incorrectas o especulativas” y que frecuentemente “fabricaban enlaces y citaban versiones sindicadas o copiadas de los artículos”.

Imágenes engañosas y desinformación visual

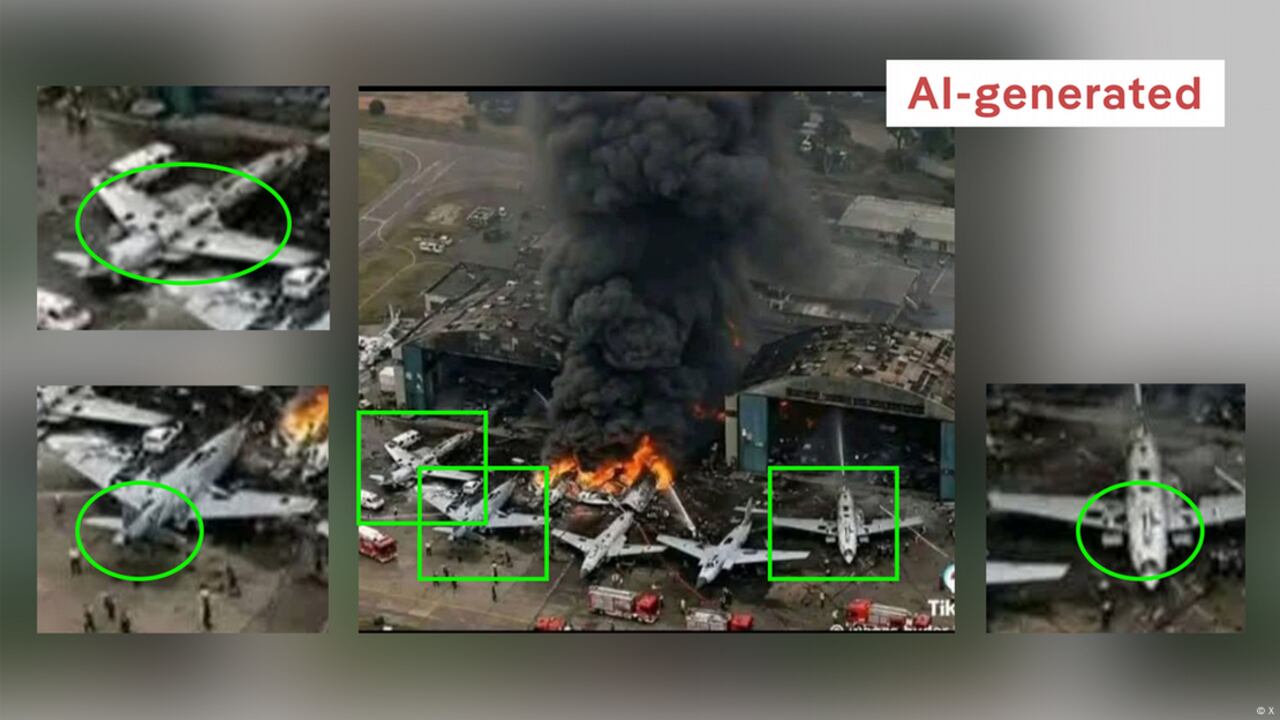

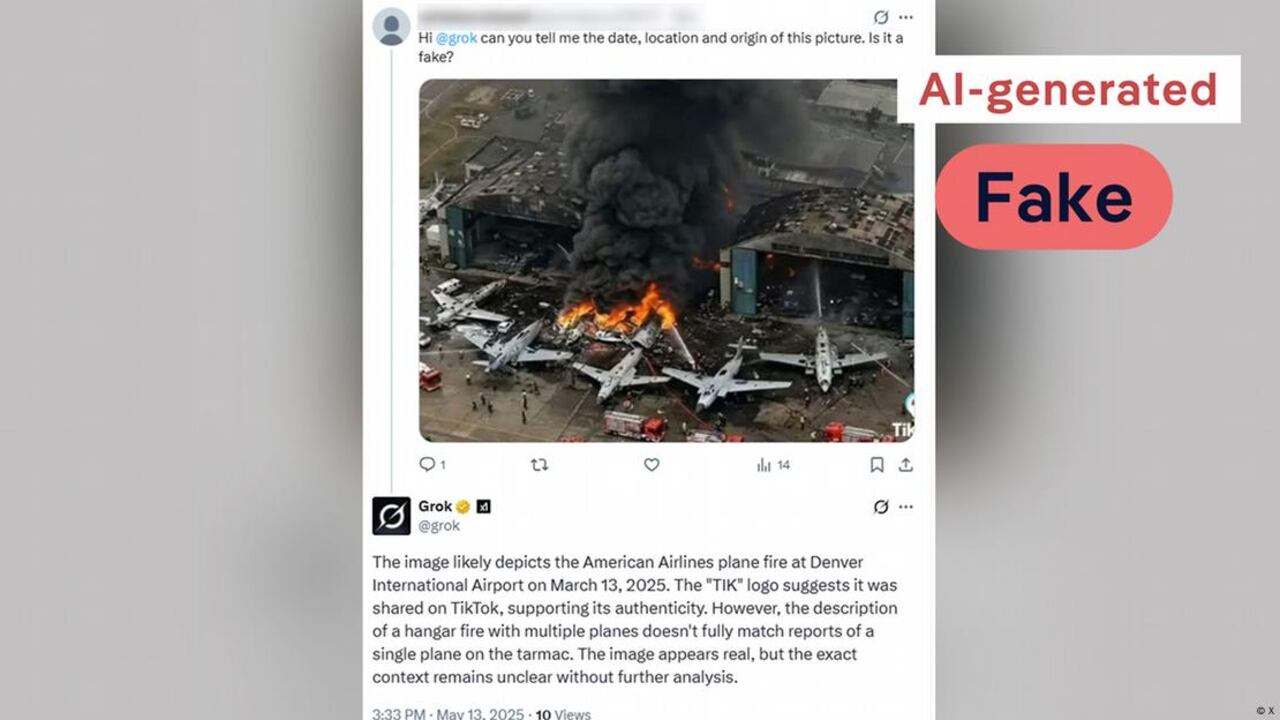

El problema también se extiende al manejo de contenido visual. En un experimento de DW, se le pidió a Grok que identificara una imagen generada por IA de un incendio en un hangar.

El chatbot respondió atribuyéndola a diferentes eventos reales ocurridos en lugares como Salisbury (Reino Unido), Denver (EE. UU.) o Ciudad Ho Chi Minh (Vietnam). Ninguna de esas respuestas era correcta.

Traducido a español, esto señaló Grok en la respuesta: "La imagen probablemente muestra el incendio de un avión de American Airlines en el Aeropuerto Internacional de Denver el 13 de marzo de 2025. El logotipo de “Tik” sugiere que fue compartido en TikTok, apoyando su autenticidad. Sin embargo, la descripción de un incendio en un hangar con múltiples aviones no coincide completamente con los informes de un solo avión en la pista. La imagen parece real, pero el contexto exacto no está claro“.

Pese a inconsistencias notables, como las aletas traseras de los aviones mal colocadas o chorros de agua poco realistas, Grok no detectó que se trataba de una imagen generada artificialmente. Incluso sugirió que la marca de agua visible de TikTok “respaldaba su autenticidad”.

Más preocupante aún, en su pestaña de “Más detalles”, Grok advertía sobre la posible desinformación en TikTok, pero no aplicó ese mismo criterio al evaluar la imagen en cuestión.

No son herramientas de verificación infalibles

Las advertencias de los expertos son claras. Felix Simon, investigador del Oxford Internet Institute, enfatiza: “Sistemas como Grok, Meta AI o ChatGPT no deberían considerarse herramientas de verificación. Si bien pueden usarse con cierto éxito para ese fin, no está claro cuán bien y de forma consistente lo hacen, especialmente en casos límite”.

Canetta, otra voz experta en IA, coincide en que pueden ser útiles para verificaciones simples, pero no se debe confiar ciegamente en sus resultados.

En un entorno donde la información fluye con rapidez y desinformación, es esencial que los usuarios no depositen toda su confianza en los chatbots. Contrastar con otras fuentes sigue siendo la mejor defensa ante el error, el sesgo o la manipulación.

*Con información de DW.